继SuperCLUE中文大模型评测基准8月榜单发布之后,国内又一权威评测体系FlagEval公布最新9月榜单评测结果。

和前段时间大语言模型领域在各大基准评测中争奇斗艳,你方唱罢我登场的局面不同。夺得这两份重量级榜单榜首的均为刚刚发布的Baichuan 2大模型。

FlagEval是北京智源人工智能研究院推出的大模型评测体系及开放平台,旨在建立科学、公正、开放的评测基准、方法、工具集,协助研究人员全方位评估基础模型及训练算法的性能。FlagEval 大语言模型评测体系当前包含6大评测任务,近30个评测数据集,超10万道评测题目。

FlagEval主观评测全新升级,Baichuan 2排名第一

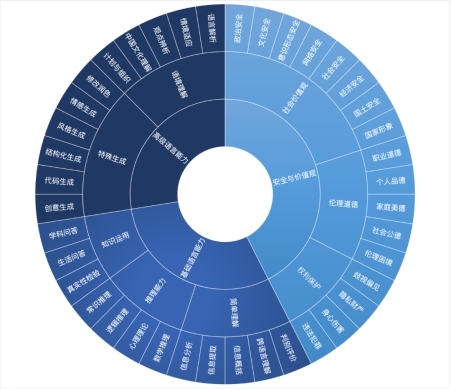

在9月评测中,FlagEval进行了评测框架升级,细化“安全与价值观”与“推理能力”。依据最新版的能力框架,FlagEval 团队同步更新了智源自建的 Chinese Linguistics amp; Cognition Challenge 主观评测数据集题库v2.0,题目数量扩充3倍,采用“多人‘背靠背’评测+第三方仲裁”的方式保证评测结果的一致性。

基于最新 CLCC v2.0主观评测数据集,重点评测了近期大热的 7 个开源对话模型。从整体结果来看,Baichuan2-13b-chat、Qwen-7b-chat、Baichuan2-7b-chat名列前茅,准确率均超过 65%。

客观评测显示Baichuan 2在中英文领域均全面超越Llama2 在基座模型榜单中,Baichuan 2、Qwen、InternLM、Aquila 的客观评测结果表现均超越同参数量级的 Llama 及 Llama2 模型。

在 SFT 模型榜单中,Baichuan2-13B-chat、YuLan-Chat-2-13B、AquilaChat-7B 名列前三。

在客观评测两个榜单中,Baichuan 2均表现出优异性能,基础模型测试在中英文领域均全面超越Llama2。

当下,国内大模型发展如火如荼,未来,谁能在大模型竞争格局中占据核心地位仍是未知。但不难想象的是,Baichuan 2既已实现对LLaMA2的超越,再加上惊人的迭代速度和良好的开源生态支持,必将推动国内开源生态不断进步、相互促进,对中国大模型行业带来积极影响。

郑重声明:此文内容为本网站转载企业宣传资讯,目的在于传播更多信息,与本站立场无关。仅供读者参考,并请自行核实相关内容。